VIOLENCIAS

Rosalía, Zendaya o alumnas: la violencia machista a través de la pornografía que se ceba con cualquier mujer

Las 'deepfakes', imágenes trucadas y no consentidas de celebridades y gente corriente, llenan internet

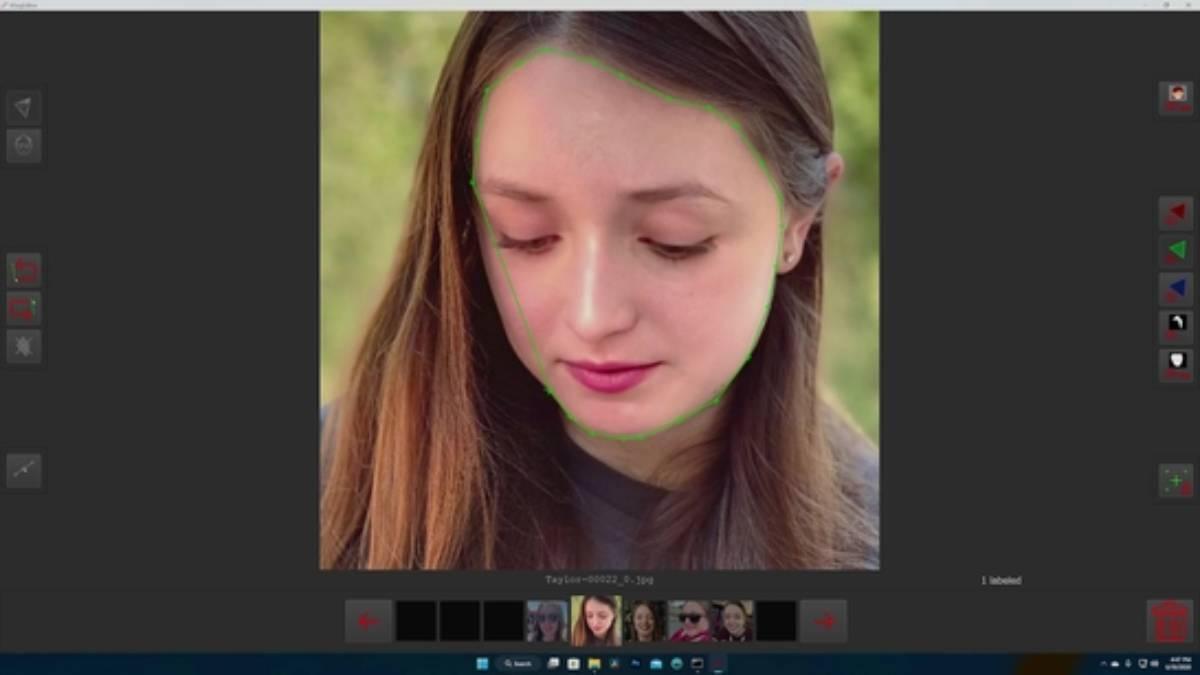

Fotograma de 'Another body', el documental que se estrena en Filmin el 8 de diciembre.

Un contacto te manda un mensaje directo. Te pregunta qué tal estás para, después, decirte que lo siente mucho, pero que tienes que ver esto. Es un enlace de PornHub, una de las páginas porno más vistas en toda España y en el mundo entero. Así que piensas que le han hackeado. Pero no, te sigue insistiendo. Abres el enlace y ahí estás tú: protagonizando imágenes para adultos que nunca has grabado.

Entonces viene el mal cuerpo y la ansiedad; el no saber qué hacer, el preguntarse cómo ha acabado tu imagen ahí o quién ha podido hacerte algo así. A ese viaje de incertidumbre y angustia traslada a los espectadores el documental Another Body, que sigue el caso de una joven estudiante de Ingeniería, Taylor, que se descubre en un vídeo pornográfico que jamás grabó, pero que ha sido manipulado digitalmente para reemplazar, de forma convincente, la imagen de la actriz porno por la suya.

A pesar de que Taylor no se llama Taylor, y de que su propia cara ha sido modificada para esta producción audiovisual, su historia no es una excepción. La creación de deepfakes (contenido multimedia alterado por inteligencia artificial para que parezca realista) está siendo ampliamente utilizada en la industria del porno: hasta ocho de las diez principales páginas web de pornografía incluyen contenidos hechos por medio del deepfak según un estudio de la compañía especializada en ciberseguridad Deeptrace, publicado en 2019.

Un montón de famosas

En concreto, el laboratorio identificó 14,678 videos deepfake en varias plataformas de transmisión y sitios de pornografía, un aumento del cien por cien con respecto a su medición anterior, en diciembre de 2018. Además, el trabajo también encontró que la gran mayoría de los sujetos de estos videos falsos en internet (un 96 por ciento) son mujeres, en su mayoría celebridades, cuyas imágenes se convierten en fantasías sexuales sin su consentimiento.

Basta hacer una simple búsqueda en internet para que aparezcan vídeos protagonizados por algunas de las mujeres más famosas del mundo, como Anne Hathaway, Ariana Grande, Emma Stone, Zendaya o Julia Roberts. El reguetonero JC Reyes (Reyes Cortés) subió el pasado mes de mayo a sus stories de Instagram una foto falsa de Rosalía en la que esta aparece enseñando los pechos. La presentadora e influencer Laura Escanes denunció un caso parecido.

Con el tiempo, las mujeres a las que se dirigen no son sólo celebridades: puedes conseguir porno deepfake hecho por encargo prácticamente de quien quieras. Basta con tener suficientes fotos de la persona. "Un creador se ofreció en Discord a hacer un deepfake de cinco minutos de una 'chica personal', es decir, cualquier persona con menos de dos millones de seguidores en Instagram, por 65 dólares", informó la NBC.

Mujeres corrientes

El auge del porno deepfake ya está teniendo un impacto masivo en la vida de muchas mujeres corrientes. A principios de este 2023, un gamer de Twitch llamado Brandon 'Atrioc' Ewing admitió haber comprado y visto pornografía deepfake de sus colegas femeninas. Lo hizo porque, sin querer, mostró en vivo ventanas del navegador abiertas a un sitio web de alguien que hacía deepfakes a streamers populares. En una disculpa pública, aseguró que lo había impulsado “curiosidad morbosa” y que ver pornografía no consensuada no es un “patrón de comportamiento”. Su mujer, Arianna Ewing, se sentó al fondo de la corriente y lloró.

Una de las mujeres que habrían sido atacadas, la streamer QTCinderella, habló sobre el precio que había tenido en su salud mental. “Así es sentirse violada, así es sentirse aprovechada”, aseguró en una transmisión en vivo el 30 de enero. “No debería ser parte de mi trabajo tener que pagar dinero para que retiren estas cosas. No debería ser parte de mi trabajo ser acosado, ver fotos mías 'desnudas' esparcidas por ahí”.

Pero si ha habido un hecho en España que confirmó que estamos ante una nueva forma de violencia machista ha sido el caso de Almendralejo, donde un grupo de menores crearon y difundieron imágenes de 22 niñas trucadas con inteligencia artificial.

Los vídeos se quedan para siempre

El documental Another Body, que se estrena el próximo 8 de diciembre en Filmin, ha ganado el Premio Especial del Jurado en el SXSW Film Festival de Austin y recibió dos nominaciones en los British Independent Film Awards, los premios del cine independiente británico. A través de él, directores noveles Sophie Compton y Reuben Hamlyn alertan sobre una problemática real frente a la que las autoridades no están actuando en la mayoría de territorios. En el caso específico de Estados Unidos, por ejemplo, los llamados deepfakes son legales en 48 de los 50 estados, aunque, tal y como explican Compton y Hamlyn, hasta el 90% de los que encontraron en la red utilizan imágenes de mujeres sin su consentimiento para generar vídeos pornográficos.

Aseguran que la mayoría de víctimas no saben quién es el autor de la agresión, a qué rincones del planeta ha llegado el vídeo y quienes lo han visto: "Una vez el vídeo aparece en Internet, se queda allí para siempre".

Efecto silencioso

Amnistía Internacional ha acuñado el término "efecto silencioso" para hablar de las consecuencias que estos ataques, que afectan de manera desproporcionada a más mujeres que hombres, tienen sobre las víctimas. Por eso, junto a la película, los directores lanzaron la campaña #MyImageMyChoice para apoyar a los afectados y poner el foco en el hecho de que cualquier persona con un perfil en las redes sociales, sea famosa o no, es una víctima potencial de los deepfakes.

"El abuso de la imagen íntima puede tener impactos devastadores e incluso potencialmente mortales. Pero los gobiernos y las plataformas tecnológicas no están haciendo nada para abordarlo. Los sitios web de abuso de imágenes íntimas, basados en la violación del consentimiento, se han convertido en prósperos negocios en línea. Empresas como Google, Visa y Verizon están permitiendo y sacando provecho de este abuso y normalizando la misoginia. Estamos haciendo campaña para que los gobiernos y las empresas de tecnología #BlockMrDeepfakes y los más de 3000 sitios dedicados al abuso de género en línea", aseguran en la campaña.

En Europea, el Instituto Europeo para la Igualdad de Género considera estas creaciones una forma más de agresión machista, según lo dispuesto en su informe sobre ciberviolencia contra las mujeres. En España, la nueva ministra de Igualdad, Ana Redondo, ha anunciado que quiere lograr una Estrategia Nacional donde se aborde el acceso al porno de los menores, por lo que también podrían caber esta nueva forma de violencia machista, que será abordada en la próxima reunión informal ministerial de Igualdad.

Qué es el 'deepfake'

El deepfake logra replicar los rasgos de una cara a partir de una gran cantidad de imágenes de esa persona. O la voz, en en el caso de que haya varios audios, como explica Andrés Visus, director de desarrollo de negocio de IA en Predictland. Lo hace a través de técnicas de Machine Learning denominadas Deep Learning, aprendizaje profundo, que utiliza algoritmos de redes neuronales. Después, es capaz de superponer esos patrones de la imagen sobre el rostro de otra persona, sustituyendo sus rasgos. Es así como se hizo famoso anuncio de Lola Flores en una campaña de Cruzcampo.

- Viggo Mortensen: "En España se está copiando lo que ya le ha funcionado a Trump

- La Audiencia Nacional obliga a García Castellón a imputar a un policía por facilitar datos a Villarejo

- El antes, durante y después del rock radical vasco: "Con la desaparición de ETA se produce un momento musical hedonista

- De una piscina en el Manzanares a una fábrica de coches en Lavapiés: todo el patrimonio que ya no volverás a ver en Madrid

- Con el matrimonio holandés que compró un pueblo abandonado de Burgos: "Ya hay gente interesada en venir a vivir

- Así es por dentro el Palacio de la Trinidad, cerrado al público durante años: "Es el más desconocido de Madrid

- El milagro de Anguix, el pueblo con paro cero de la España vaciada: "Quien quiere trabajar trabaja

- Qué fue de… Eva Nasarre, la presentadora de sonrisa eterna que enseñó a hacer gimnasia a los españoles